Chat with RTX降低了部署门槛,而且支持本地ai部署,可避开监管,类似于一个不联网的图书馆,能够对文档进行索引和总结;它在一些特定场景中具有实际用途,例如在CTF线下断网比赛中,或者进行文档总结(OSINT)时能够发挥作用。

英伟达Chat with RTX:本地AI部署深度探究

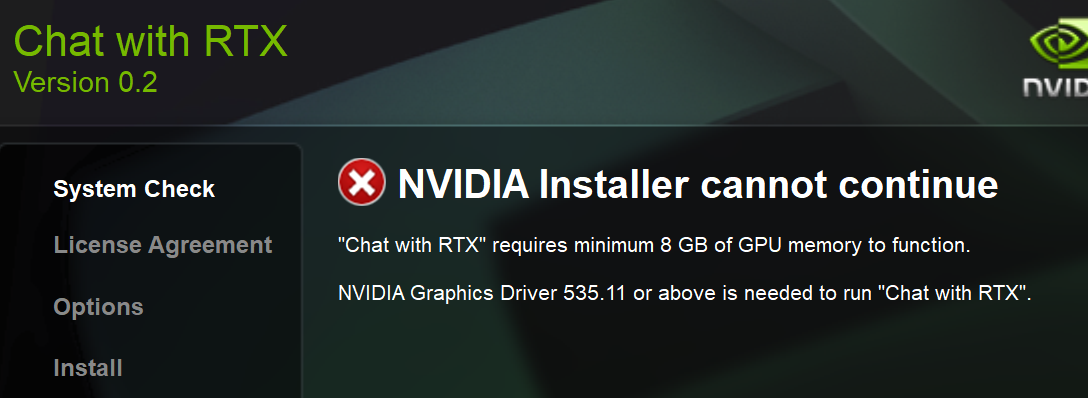

硬件要求

使用Chat with RTX,首先电脑配置得满足要求,需要一片RTX 30或RTX 40系列8GB显存以上的显卡、16GB以上的内存、Windows11系统、535.11以上的显卡驱动、35GB的存储空间。

笔记本也可以跑,但是如果不是RTX的显卡 是不符合硬件要求的, 安装的第一步就会被卡住。

文件下载链接

文件很大 35GB,存储空间要充足。

https://www.nvidia.cn/ai-on-rtx/chat-with-rtx-generative-ai/

安装

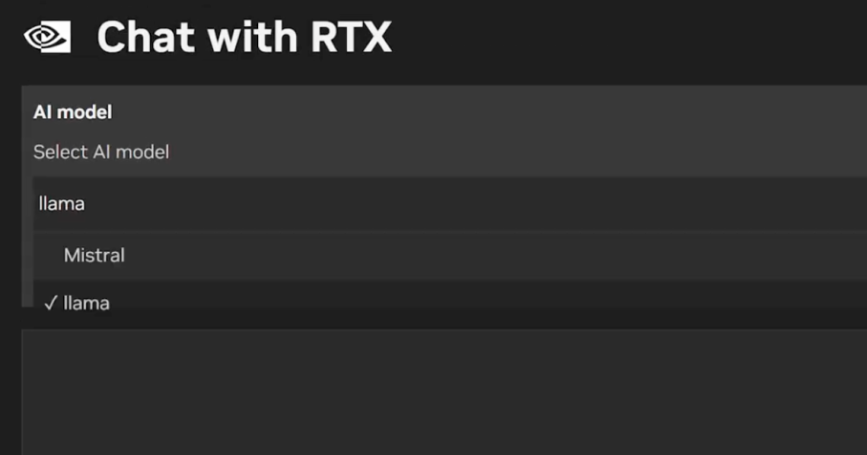

Chat With RTX并非是英伟达自己搞了个大语言模型(LLM)。

它背后所依靠的仍是两款开源LLM,即Mistral和Llama 2,用户在运行的时候可以根据喜好自行选择。下载所有必要文件会占用相当大的存储空间 ——50GB 到 100GB,具体取决于所选模型。

安装完LLM大模型之后,就可以在Chat With RTX中上传本地文件。支持的文件类型包括txt,.pdf,.doc/.docx和.xml。

亮点

Chat with RTX在Windows RTX pc和工作站上本地运行,因此提供的结果很快-并且用户的数据保留在设备上。与依赖基于云的LLM服务不同,Chat with RTX让用户在本地PC上处理敏感数据,而无需与第三方共享或连接互联网。(对于pdf可投喂+本地隐私 亮点)

每个人的CHAT With RTX都是不同的,主要区别与你给AI投放的资料,通过移入自己的文档、笔记、视频或其他数据,CHATWith RTX会通过检索资料内容,快速给予你合适的答案,哪怕是资料不相关的内容,AI也会回答你相对合适的答案。

Chat With RTX另一个亮点功能,就是可以根据在线视频做回答。可以把一个油管视频的链接“投喂”给它,然后向Chat With RTX提问。

实测

缺点

Chat with RTX存在一些缺点,其中一个显著的问题是在搜索视频功能中,测试中发现它竟然下载了与查询无关的视频文字记录,导致搜索结果不准确。

另外,如果向Chat with RTX“投喂”大量文件,比如让其为25000个文档编制索引,系统会直接崩溃,表现为“罢工”。

此外,该工具在处理上下文方面存在不足,无法在后续问题中建立基于先前问题的上下文。

另一个问题是下载Chat with RTX需要较长时间,因为文件大小达到35GB。工具的中文支持度不好。

Chat with RTX在处理人类感觉相似但表达方式不同的问题时表现差异较大,机器理解能力有限。

最后,该工具的回答是基于其中某一份资料的内容,无法整合所有资料内容来全面回答提问,存在信息孤岛的问题。

优点

与需要联网使用的ChatGPT等聊天机器人不同,Chat with RTX能够在本地运行,支持检索、分析保存在电脑上的文件,包括文本、PDF、.doc、.docx 和 .xml 等格式。比如,在搜索电脑上的文档时,Chat with RTX展现出了出色的速度和精准度。此外,Chat with RTX在总结方面和保障安全性也表现出较高的水平。

技术解构

英伟达的Chat with RTXAI利用本地RTX显卡运行,借助检索增强生成(RAG)模型、NVIDIA TensorRT以及NVIDIA RTX等技术实现其功能。这一解决方案的优势在于本地化部署,充分利用了RTX显卡的计算能力。其中,RAG模型通过检索增强生成的方式,结合检索和生成两种技术,为用户提供更精准的信息响应。另外,NVIDIA TensorRT是一款用于高性能深度学习推理的软件,为Chat with RTXAI提供了加速计算的支持,进一步提升了系统的性能和效率。

整体而言,英伟达的Chat with RTXAI通过这些技术组合,为用户提供了更快速、更可靠的文本处理和信息检索体验。

改善 :加中文LLM大模型

NVIDIA Chat with RTX 天生是英文模型,如果要用中文资料进行本地训练,为其添加中文 LLM 大模型支持即可。

例如下面这个教程:

【为 NVIDIA Chat with RTX 添加中文 LLM】https://www.bilibili.com/video/BV1DK421b7JX?vd_source=096b7bc1564cfe7dff4f08025c3f4710

思考与总结:

Chat with RTX降低了部署门槛,而且支持本地ai部署,可避开监管。但它默认的模型是检索增强生成RAG,这个模型太小了,不能记住上下文,没有思考/逻辑的能力,重点只在于文档检索。

总体而言,英伟达的AI更适用于个人私有文档检索,类似于一个不联网的图书馆,能够对文档进行索引和总结。

用处探究

Chat with RTX在一些特定场景中具有实际用途,例如在CTF线下断网比赛中,或者进行文档总结(OSINT)时能够发挥作用。

存在问题:最高支持文档上限仍有待考验

有个例子: Chat with RTX为25000个文档编制索引 就崩溃了,具体支持的上限是多少,就无法确定了,有待检验 。这个AI还在初级水平,具体支持的上限尚不明确,需要进一步测试和验证。这也是用户在个人使用过程中需要注意的问题,可能需要根据具体需求进行优化和调整。